NVIDIA объявила о разработке инструмента Audio2Face с открытым исходным кодом, который генерирует реалистичные выражения лица и движения губ для 3D-аватаров на основе звука. Теперь разработчики могут бесплатно использовать модель, SDK и фреймворк для обучения, создавая персонажей для игр, приложений и даже прямых трансляций.

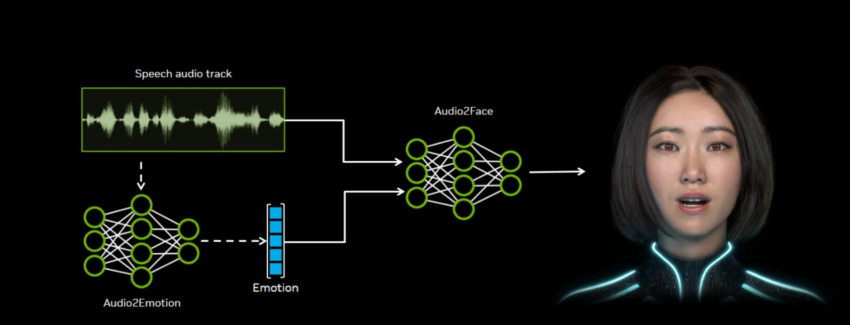

Audio2Face анализирует акустические характеристики голоса — интонацию, фонемы, тембр — и преобразует их в анимационные данные, которые накладываются на 3D-модель. Это позволяет точно синхронизировать движение губ и мимику как в предварительно записанном контенте, так и в режиме реального времени. NVIDIA подчёркивает, что технология способна работать с эмоциональными нюансами речи, делая цифровых персонажей более «живыми».

Разработчики уже интегрировали Audio2Face в свои проекты: в частности, Farm51 использовала ее в игре Chernobylite 2: Exclusion Zone , а также технология появится в Alien: Rogue Incursion Evolved Edition .

Помимо моделей, NVIDIA также открыла обучающую платформу, позволяющую адаптировать систему к конкретным сценариям. Также доступны плагины для Unreal Engine 5 и Autodesk Maya, упрощающие интеграцию.

Таким образом, открытие Audio2Face может значительно ускорить создание лицевой анимации и сократить затраты на ручную анимацию, открывая новые возможности для игр, медиа и виртуальных сервисов.